Grok 3 Mini Reasoning: Außergewöhnliche Intelligenz zum Schnäppchenpreis

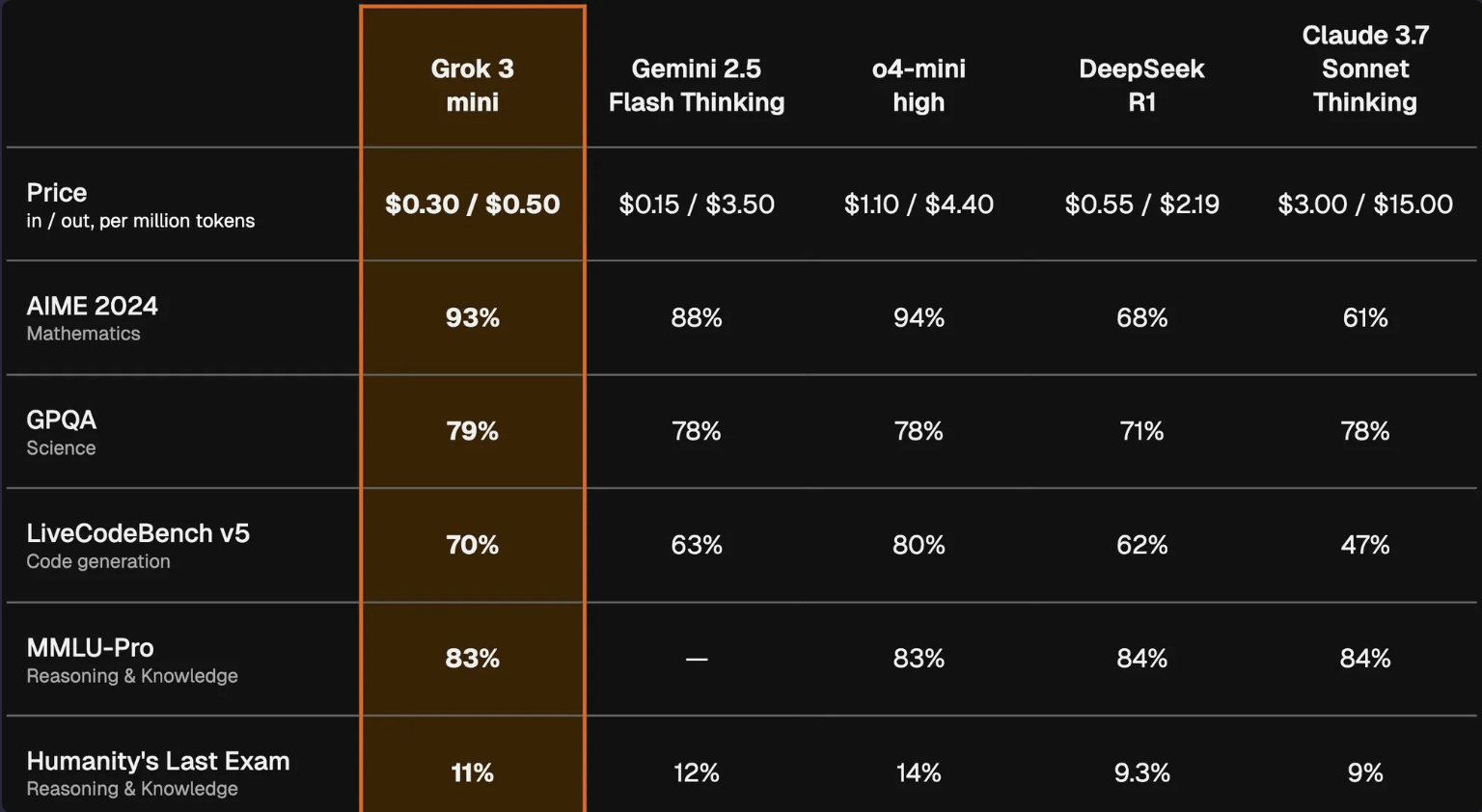

xAI hat offiziell öffentliche APIs für seine Grok 3- und Grok 3 Mini-Modelle gestartet, was über die anfängliche Verfügbarkeit über die Grok-Chat-Schnittstelle hinausgeht. Mit der Veröffentlichung sind nun vollständige Benchmark-Ergebnisse verfügbar, und sie sind beeindruckend—insbesondere für Grok 3 Mini (hohes Reasoning).

Grok 3 Mini (hohes Reasoning) sticht auf der Kurve von Intelligenz vs. Preis hervor und erreicht eines der höchsten Artificial Analysis Intelligence Index-Wertungen aller Zeiten—und bleibt dabei günstiger als Alternativen wie DeepSeek R1.

Grok 3 Modellübersicht

Die Grok 3-Familie von xAI umfasst derzeit sechs Varianten:

- Grok 3

- Grok 3 Fast

- Grok 3 Mini (niedriges Reasoning)

- Grok 3 Mini Fast (niedriges Reasoning)

- Grok 3 Mini (hohes Reasoning)

- Grok 3 Mini Fast (hohes Reasoning)

Dieser Beitrag konzentriert sich auf Intelligenz-Benchmarks; eine vollständige Leistungsübersicht aller sechs Versionen folgt in Kürze.

Benchmark-Intelligenz

Grok 3 markiert den Eintritt von xAI an die Spitze der KI-Fähigkeiten. Sowohl Grok 3 Mini (hohes Reasoning) als auch Grok 3 selbst gehören in die Top Five ihrer jeweiligen Kategorien. Bemerkenswert ist, dass Grok 3 Mini Reasoning DeepSeek R1 und Claude 3.7 Sonnet (mit einem Reasoning-Budget von 64k) im Intelligence Index übertrifft.

Wettbewerbsfähige Preise

Grok 3 Mini Reasoning bietet ein außergewöhnliches Preis-Leistungs-Verhältnis. Die Version mit Basistempo kostet 0,30 $ / 0,50 $ pro 1 Million Eingabe/Ausgabe-Tokens—fast zehnmal günstiger als andere ähnlich leistungsfähige Modelle:

- OpenAI o4-mini:

1,10 $ / 4,40 $ - Gemini 2.5 Pro:

1,25 $ / 10 $ - Grok 3 Mini Fast:

0,60 $ / 4,00 $ - Grok 3:

3,00 $ / 15,00 $

End-to-End-Latenz

Die Standardgeschwindigkeitsversion von Grok 3 liefert 500 Tokens in 9,5 Sekunden, während Grok 3 Mini Reasoning aufgrund des intensiveren Reasoning-Prozesses länger braucht—27,4 Sekunden. Vergleiche mit den Fast-Varianten werden in Kürze erwartet.

Quelle: Benchmark-Einblicke von @ArtificialAnlys

2 Replies to “Grok 3 Mini: Das kosteneffiziente KI-Modell von xAI für logisches Denken und Mathematikaufgaben”