Google stellt mit Gemma 3 QAT (Quantization-Aware Training) neue Versionen seines KI-Modells vor, die speziell für eine effiziente Nutzung auf Consumer-GPUs entwickelt wurden. Durch Quantization-Aware Training werden die Modelle bereits während des Trainings auf eine spätere Quantisierung vorbereitet, sodass sie auch mit niedriger Präzision, etwa 4-Bit-Integer-Formaten, eine hohe Modellqualität und Genauigkeit beibehalten. Dies reduziert den Speicherbedarf und die Modellgröße erheblich, wodurch der Einsatz performanter KI-Modelle auf handelsüblicher Hardware wie Gaming-GPUs möglich wird.

In der Entwicklung von Gemma 3 kamen fortschrittliche Trainingsverfahren zum Einsatz:

- Knowledge Distillation: Die Modelle profitieren vom Wissen größerer Teacher-Modelle.

- Erweitertes Token-Budget: Das 27B-Modell wurde mit bis zu 14 Billionen Tokens trainiert.

- Vielfältige Trainingsdaten: Der Datensatz umfasst Text- und Bilddaten mit einem starken Fokus auf mehrsprachigen Inhalten im Vergleich zu Vorgängerversionen.

- Post-Training-Techniken: Speziell für die instruktionstunierten Modelle wurden Methoden wie BOND, WARM, WARP und Reinforcement Learning from Human Feedback (RLHF) eingesetzt.

Für Gemma 3 wurden explizite Sicherheitsmaßnahmen umgesetzt:

- Umfassende Filterung der Trainingsdaten zur Entfernung von persönlichen Daten, unsicheren und doppelten Inhalten.

- Feintuning mit RLHF, das gezielt 12 Kategorien von toxischen Inhalten adressiert.

- Eingebaute Mechanismen, die das Modell dazu befähigen, unsichere Anfragen abzulehnen.

- On-Device-Redaktion sensibler Informationen mittels Token-Filtern.

- Umfangreiche Evaluierung gegen synthetische adversarielle Anfragen und gezielte Tests für risikobehaftete Domänen.

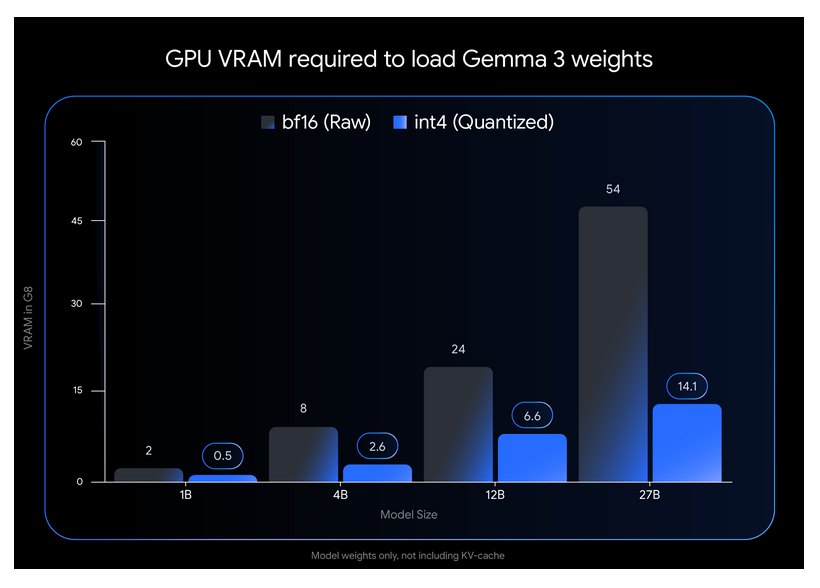

Die quantisierten QAT-Modelle existieren beispielsweise als 12B oder 27B Varianten und werden im effizienten GGUF-Format ausgeliefert. Dank QAT erreichen diese Modelle eine vergleichbare Qualität wie die bfloat16-Version, benötigen aber signifikant weniger Arbeitsspeicher beim Laden und Ausführen auf lokalen Geräten.

Mit der Veröffentlichung der Gemma 3 QAT-Modelle macht Google aktuelle KI-Technologie noch zugänglicher und wirtschaftlicher nutzbar für Entwickler, Unternehmen und Forschungseinrichtungen, die Wert auf hohe Leistung bei reduziertem Ressourcenverbrauch legen.

Quelle:

https://developers.googleblog.com/en/gemma-3-quantized-aware-trained-state-of-the-art-ai-to-consumer-gpus/?linkId=14034718&utm_source=alphasignal